Das Auftauchen von Cobots, die mit Menschen im selben Raum interagieren oder in nächster Nähe sicher arbeiten sollen, ist eine bedeutende Entwicklung. Cobots stehen in deutlichem Kontrast zu herkömmlichen Industrierobotern, die autonom arbeiten bei gewährleisteter Sicherheit durch Trennung von menschlichem Kontakt. Es handelt sich derzeit um einen sehr kleinen Teil des gesamten Robotikmarkts, jedoch um einen Bereich, von dem wir (und eine Anzahl anerkannter Analysten) glauben, dass er in den nächsten fünf Jahren schnell wachsen wird, und zwar für Anwendungen in der Fertigung, dem Gesundheitswesen und im Einzelhandel. Die Corona-Pandemie beschleunigt diesen Trend, da sie die Akzeptanz gegenüber verstärkter digitaler Transformation und Automation erhöht. In Umgebungen, in denen das Einhalten von 2m Abstand zwischen den Menschen schwierig oder unglaublich ineffizient ist, werden Cobots zuerst eingesetzt werden. Große Kaufhäuser wie Walmart nutzen Roboter bereits zur Fußbodenreinigung ihrer Filialen. Zunehmen wird der Einsatz übergroßer Roombas zum Putzen in Schulen, Firmen und Krankenhäusern. Angesichts der vorhergesagten kurzfristigen Verlangsamung im Rennen um selbstfahrende Fahrzeuge dürften viele Technologieschmieden in diesem Bereich hin zu diesen neuen Use Cases abschwenken, was spannende Spitzentechnologie in die Robotik einbringt. Da Cobots in der Nähe von Menschen agieren, müssen sie ihre Aufgaben zu jeder Zeit deterministisch ausführen. Die Sicherheit eines neben einem Cobot arbeitenden Menschen ist von größter Bedeutung. Es müssen Sicherheitszertifizierungen und Prozesse definiert und strikt eingehalten werden, wenn dieser Markt sich erfolgreich formieren soll. In diesem Bereich liegt reichlich Fokus auf künstlicher Intelligenz, um die Anwendererfahrung mit diesem Maschinentyp zu verbessern. Der Wunsch, die Lebensdauer dieser Plattformen über einen langen Zeitraum zu erhalten, bedeutet, dass ein sicheres Verfahren für Software-Updates notwendig ist, die diesen Plattformen neue Fähigkeiten ermöglicht. Bei einigen der größeren Plattformen verzeichnen wir auch Schritte in Richtung mehr Modularität, um im Laufe der Zeit auch Hardware-Upgrades zu ermöglichen. Die Hersteller der Cobot-Hardware möchten sich nicht an einen bestimmten Hardware-Anbieter gebunden fühlen, vor allem nicht auf einem so dynamischen Gebiet wie der KI, auf dem es in den kommenden Jahren zu vielen Akquisitionen, Unternehmensauflösungen und Veränderungen im Leistungsführerschaft-Ranking kommen wird.

Konsolidierung der Schnittstelle zwischen IT und OT

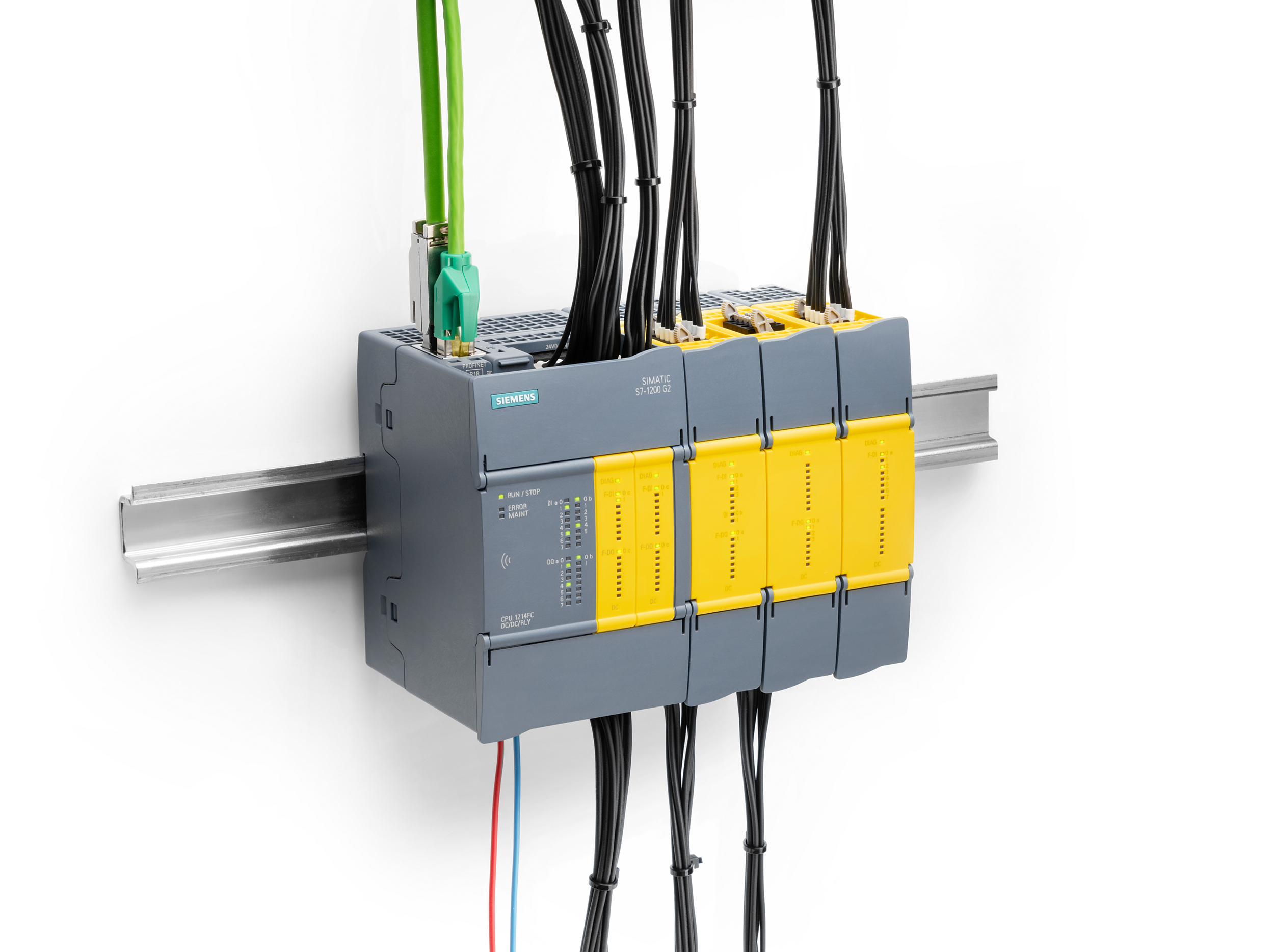

Ein zentraler Aspekt der Cobot-Entwicklung ist also, wie man die Schnittstelle zwischen Informationstechnologie (IT) und operativer Technologie (OT) konsolidiert. Wie verbindet man die Konfigurationsanweisungen zu den Roboteraufgaben (IT) mit dem, was in Echtzeit in der Fabrik passiert (OT) – vor allem den schnellen und unberechenbaren Handlungen von Menschen? In Fabrikumgebungen ist ein vergleichsweise langsames Veränderungstempo verständlich, da dort der Fokus auf Zuverlässigkeit gerichtet ist, auf möglichst lange aktive Betriebszeiten, wenig Unfälle und wenig Ausschuss. Bei OT handelt es sich daher um separate Netzwerke, die auf der Ebene der Hauptkonsole mit den IT-Netzwerken verbunden werden. Die Absicht ist, diese Fusion der IT- und der OT-Welt in die Fabrikhalle zu verschieben, sodass die Maschinen fundiertere Entscheidungen schneller treffen können. Doch dieser Herausforderung gilt es innerhalb eines kommerziell attraktiven Kosten-, Leistungs- und Größenrahmens zu begegnen. Das bedeutet, mehrere Systeme auf einem einzigen konsolidierten Board zusammenzuschrumpfen (und in immer mehr Fällen einem einzigen heterogenen Multicore-Chip). Diese Systeme müssen funktionsreiche Betriebssysteme wie Linux und Windows ausführen, gleichzeitig aber das Echtzeitverhalten der Muss-immer-auf-diese-Art-reagieren-Elemente auf der Plattform garantieren. Man bezeichnet diese als Systeme mit gemischter Kritikalität. Anwendungen müssen unterteilt werden, um sicherzustellen, dass bestimmte Applikationen nicht zum Ausfall anderer Systemelemente führen. Echtzeitbetriebssysteme auf der Basis eines Einkernprozessors (SCP) sind in der Branche wohlbekannt, die einen Echtzeit-Systementwicklungsprozess eingeführt hat, der auf der Annahme einer konstanten Worst-Case Execution Time (WCET) beruht. Diese besagt, dass das gemessene schlimmstmögliche Laufzeitverhalten einer Software-Aufgabe, wenn allein auf einem einzelnen Kern durchgeführt, gleich bleibt, wenn diese Aufgabe zusammen mit anderen Aufgaben läuft. Diese Grundannahme bildet die Grundlage für die Schedulability Analysis (Analyse des Systemverhaltens), die feststellt, dass eine Ablaufterminierung gefunden werden kann, die alle Aufgaben innerhalb ihrer jeweiligen Fristen beendet. In der Branche ist der Trend zu Mehrkernprozessor (MCP)-Systemen bereits solide etabliert. Viele dieser Multicore-Systeme wurden mit Blick auf die Anforderungen von IT-Anwendungen an Geschwindigkeit und Effizienz entwickelt und erfüllen nicht immer die Vorhersehbarkeitskriterien für Steuerungssysteme in der Avionik, Automobilindustrie oder Industrieautomation. Während die Annahme einer konstanten WCET für Single-Core-Chips korrekt ist, trifft sie wegen Core-übergreifender Interferenzen beim Zugriff auf geteilte Ressourcen NICHT bei derzeitigen Multicore-Chips zu. Interferenzen zwischen Cores können Spitzenauslastungen (Spikes) im Worst-Case-Laufzeitverhalten um mehr als das Sechsfache gegenüber einem Einzelkern verursachen. Hierauf konzentriert sich Lynx und stellt einen sicheren Hypervisor bereit, der Anwendungen sicher partitionieren und isolieren kann, gleichzeitig aber eine Reaktion im Mikrosekundenbereich auf zeitkritische Ereignisse garantiert.

Vernetzte Cobots

Hinzu kommt, dass Cobots notwendigerweise vernetzt sein müssen, nicht nur, um Sensordaten zu teilen und Anweisungen zu erhalten, auch für regelmäßige Sicherheits- und andere Updates. Ein Sicherheitsangriff beeinträchtigt ja nicht nur das System selbst, sondern potentiell jedes Gerät, auf das über die betreffende Netzwerkverbindung zugegriffen werden kann. Sicherheit muss von Anfang an miteindesignt werden anstatt in Nachhinein. Viele Angriffe haben gezeigt, dass ein komplexes System immer nur so stark ist wie sein schwächstes Glied. Vor allem industrielle Systeme haben eine lange Lebenszeit und sind manchmal über zehn Jahre oder länger im Einsatz. Der Systemarchitekt muss beim Designen bedenken, dass über einen solchen Zeitraum kein System 100-prozentig sicher zu halten ist. Es können z.B. inzwischen neue Bedrohungen auftauchen, Änderungen am System selbst vorgenommen werden, oder aber an den verbundenen Systemen, was sich dann sicherheitsgefährdend auswirkt. Stattdessen bedarf es der Früherkennung einer Systembeeinträchtigung, verbunden mit einem Weg, es zu seinem letzten bekannten guten Zustand wiederherzustellen. Und, da es sich um keine statische Umgebung handelt, muss das System neue Software datensicher herunterladen können, um die Hindernisse gegen Angriffe hochzuhalten oder tatsächlich zu erhöhen. Aus Softwareperspektive muss das System dafür ausgelegt sein zu gewährleisten, dass es sich nach dem Booten nicht umkonfigurieren lässt und dass keine Anwendung aus Zufall (oder böser Absicht) in der Lage ist, einen Ausfall des Roboters zu verursachen. Ein Lynx-System mit einem Separation Kernel kann diese Anforderungen erfüllen. Die Laufzeitarchitektur ist unten dargestellt. In den meisten Implementierungen laufen zwei Plattform-Kernel: Im Zuge einer Smart-Factory-Potenzialanalyse für ihren Kunden KSB identifizierte die Managementberatung NEONEX Opti mierungschancen bei der Beschaffung der Lieferantendokumentation sowie der Erstellung von Unterlagen zur Qualitätsprüfung entlang der Supply-Chain. ‣ weiterlesen

Signifikante Ressourceneinsparung bei Pumpenhersteller KSB

NEONEX, Fabasoft Approve & KSB: „Win-win-win-Situation“ durch starke Partnerschaft

Signifikante Ressourceneinsparung bei Pumpenhersteller KSB

1. Der Separation Kernel, der die physikalische Hardware steuert.

2. Der OS-Kernel, der die Gastanwendungen hostet.

Dieses Konzept führt eine zusätzliche Abstraktionsschicht ein. Zum Vergleich: In typischen OS-Designs ist die Hardwaresteuerung mit dem OS-Kernel integriert. Hier ist der Separation Kernel die einzige Software mit Zugriff auf die physikalische Hardware; die Anwendungskernel haben keinen Zugang zur echten Hardware und können lediglich abgebildete Ressourcen (mapped resources) verwalten. Bei diesem Softwaregestützten Hardware-Partitionierungs-Modell (Software-assisted Hardware Partitioning Model), wie es Lynx bezeichnet, sind alle Partitionsgrenzen von Anwendungsräumen ausschließlich hardwaregestützt, nach einem von einem Architekten bewusst gestalteten und formal beschriebenen Modell. Verletzt in diesem Modell eine Applikation eine Partitionsgrenze, bekommt zunächst die Hardware die Verletzung mit und fragt dann beim Separation Kernel Hypervisor nach Software-Unterstützung an, um den Ausnahmefall zu managen.

Computing

Der scharfsinnige Leser wird bemerkt haben, dass den erörterten Entwicklungen ein Trend hin zur Implementierung von Edge-Computing-Konzepten in Cobots zugrunde liegt. Edge Computing bezieht sich auf die Verlagerung der Intelligenz, der Informationsverarbeitung, zurück dorthin, wo Daten entstehen. Einfach definitiert ist die Edge das erste Gerät auf dem Weg der Daten von ihrem Enstehungsort zurück ins Zentrum des Netzwerks, in dem dann multiple Datenströme verarbeitet und Erkenntnisse aus diesen Daten abgeleitet werden. Ein Cobot verkörpert genau das. Aus Latenz-, Netzwerkverfügbarkeits- und Datenschutzgründen nutzen Cobots üblicherweise lokal am Arbeitsplatz oder auf dem Firmengelände verfügbare Computing-Ressourcen, keine Rechenressourcen aus der Cloud. Das erfolgreich in einem Kontext umzusetzen, in dem die Maschinen Seite an Seite mit und rund um Menschen herum arbeiten und potentiell Aufgaben mit hohen Sicherheitsrisiken verrichten, impliziert ein Cobot-Design, das funktions- und datensicher (safe & secure) ist. Der Beitrag zeigte diverse Kriterien auf, die hierbei zu berücksichtigen sind. Die kommerzielle Bereitstellung von Cobot-Designs an Corona-sensiblen Arbeitsstätten erfordert konsolidierte, vernetzte Plattformen, die auf Edge-Computing-Konzepten aufbauen.